Reference

https://iai.postech.ac.kr/teaching/machine-learning

https://iai.postech.ac.kr/teaching/deep-learning

위 링크의 강의 내용에 기반하여 중요하거나 이해가 어려웠던 부분들을 정리하여 작성하였고,

모든 강의 슬라이드의 인용은 저작권자의 허가를 받았습니다.

또한, 모든 내용은 아래 Notion에서 더 편하게 확인하실 수 있습니다.

>>노션 링크<<

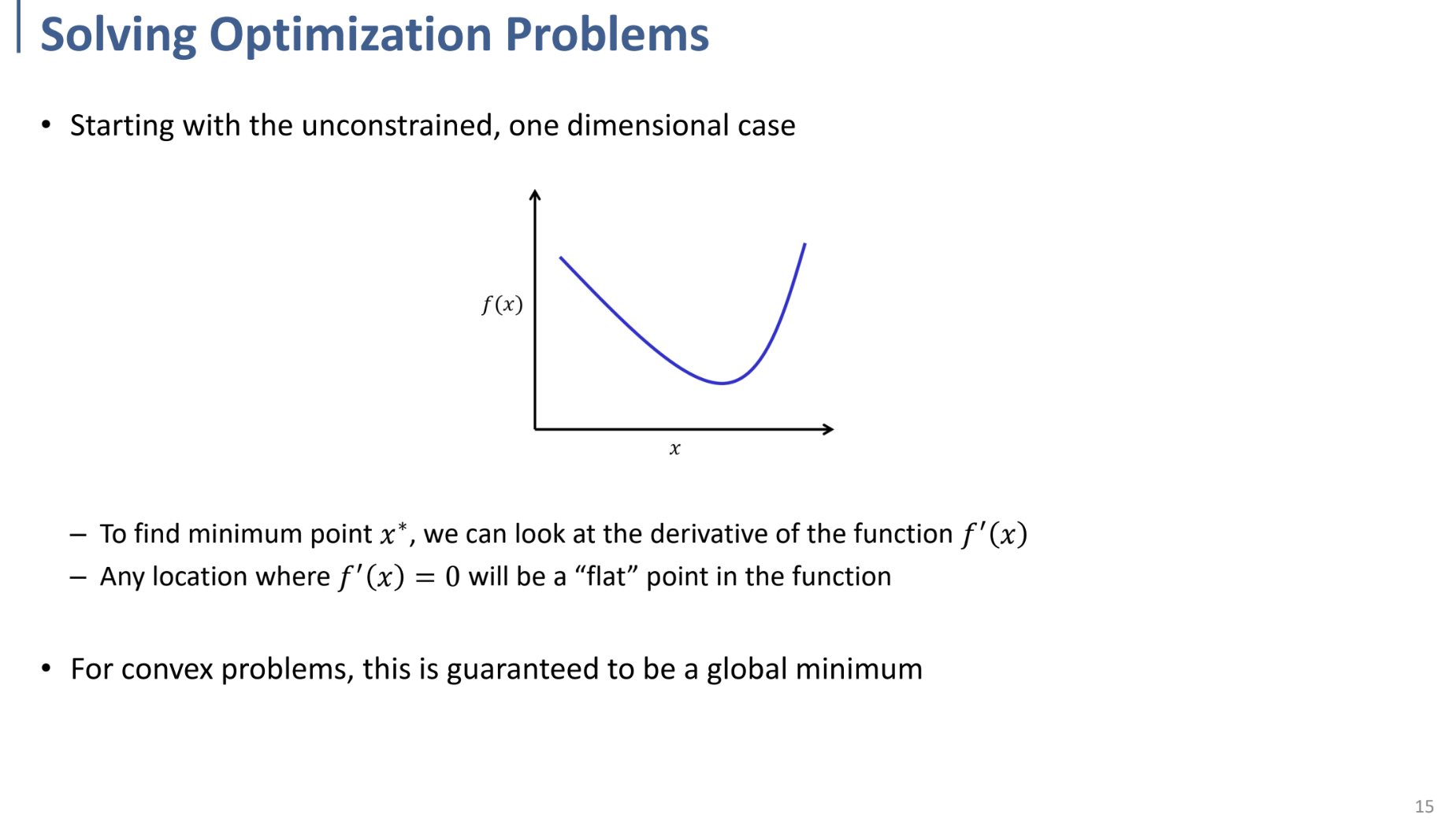

Solving Optimization Problems

unconstrained optimization problem이며, 1-dimensional한 case에서부터 보면,

이러한 형태의 optimal solution을 찾는 방법 ⇒ 미분하여 0이 되는 값 (flat point)를 찾으면 됨.

**만약 convex optimization problem이라면, 이러한 경우의 해가 항상 global한 해라고 보장됨.

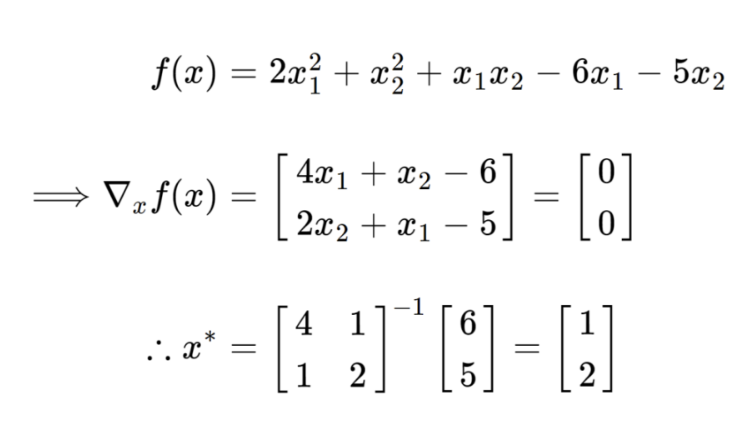

그렇다면 multi-dimensional한 문제로 넘어와서, 저러한 다차원의 x에 대해 해를 찾는 방법도 마찬가지로,

$f$에 대한 gradient가 0이 되는 값을 찾으면 된다.

각각의 dimension의 미지수에 대한 편미분을 통해 gradient vector를 구하고, 이러한 값이 0이 되는 optimal value $x^*$를 구할 수 있다.

(우측 예시처럼)

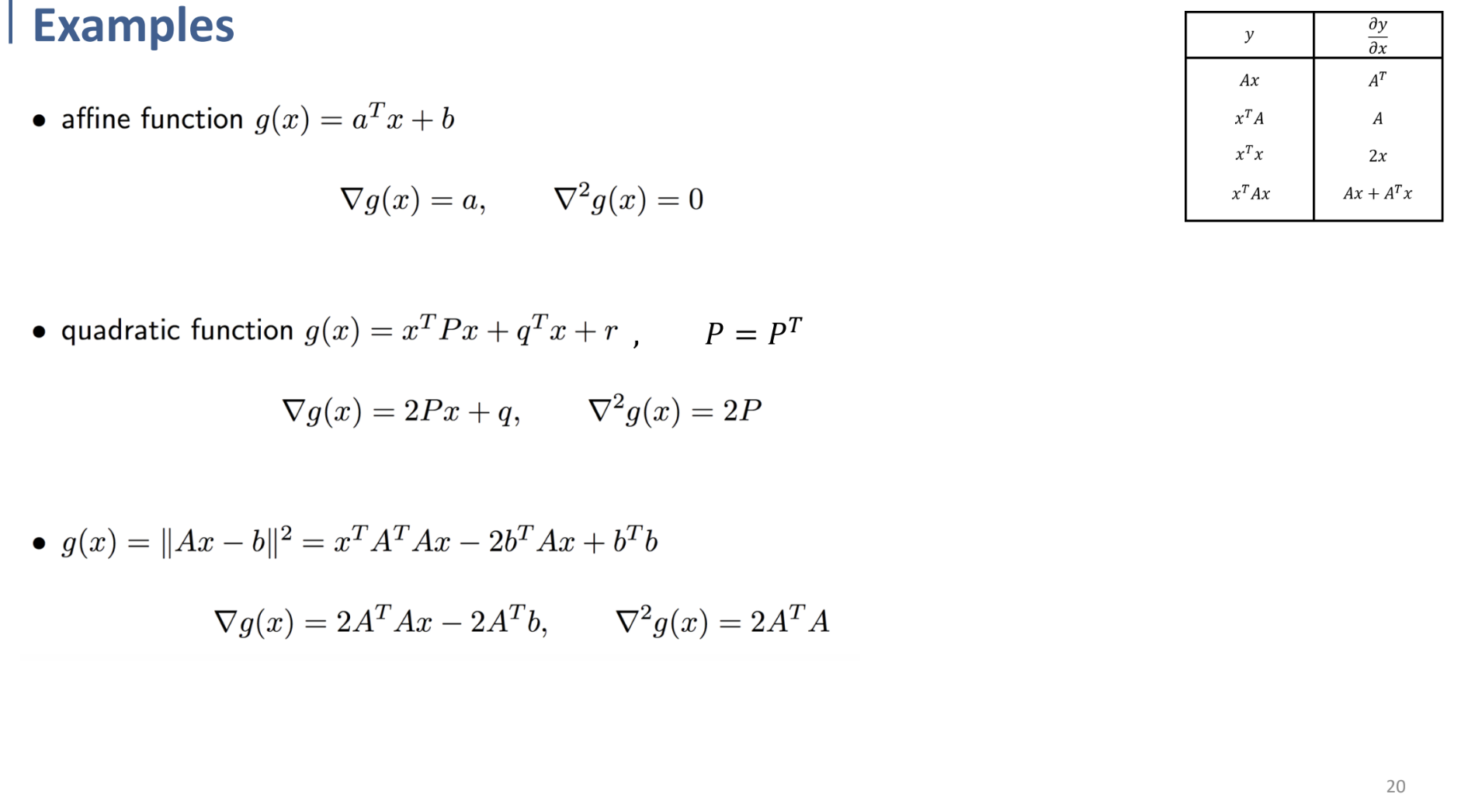

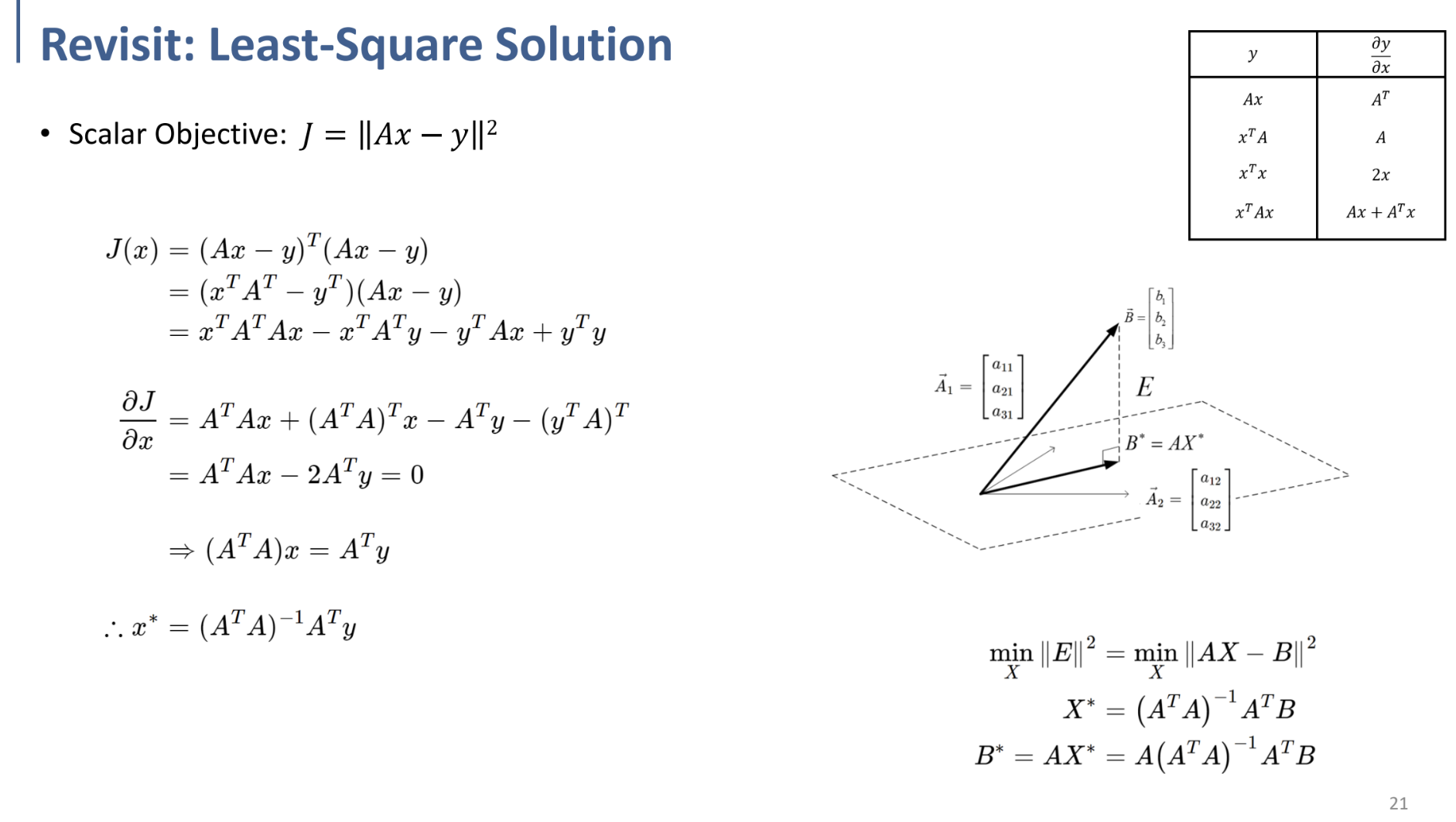

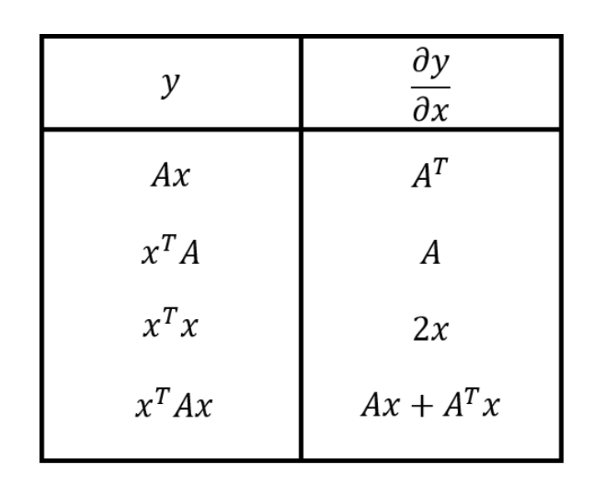

** 추가로, 앞으로 행렬에 대한 미분을 하여 gradient를 구하는 경우가 많을 테니, 행렬에 대한 미분 계산을 하는 방법 table을 우측에 기재, 앞으로 참고할 것. ⇒

+아래의 예시들을 확인하며 이해할 것.