Reference

https://iai.postech.ac.kr/teaching/machine-learning

https://iai.postech.ac.kr/teaching/deep-learning

위 링크의 강의 내용에 기반하여 중요하거나 이해가 어려웠던 부분들을 정리하여 작성하였고,

모든 강의 슬라이드의 인용은 저작권자의 허가를 받았습니다.

또한, 모든 내용은 아래 Notion에서 더 편하게 확인하실 수 있습니다.

>>노션 링크<<

Keywords

- Multivariate Linear Regression

- Non-Linear Regression

- Polynomial Regression

- Functional Approximation(Polynomial Basis, RBF Basis)

Nonlinear Regression

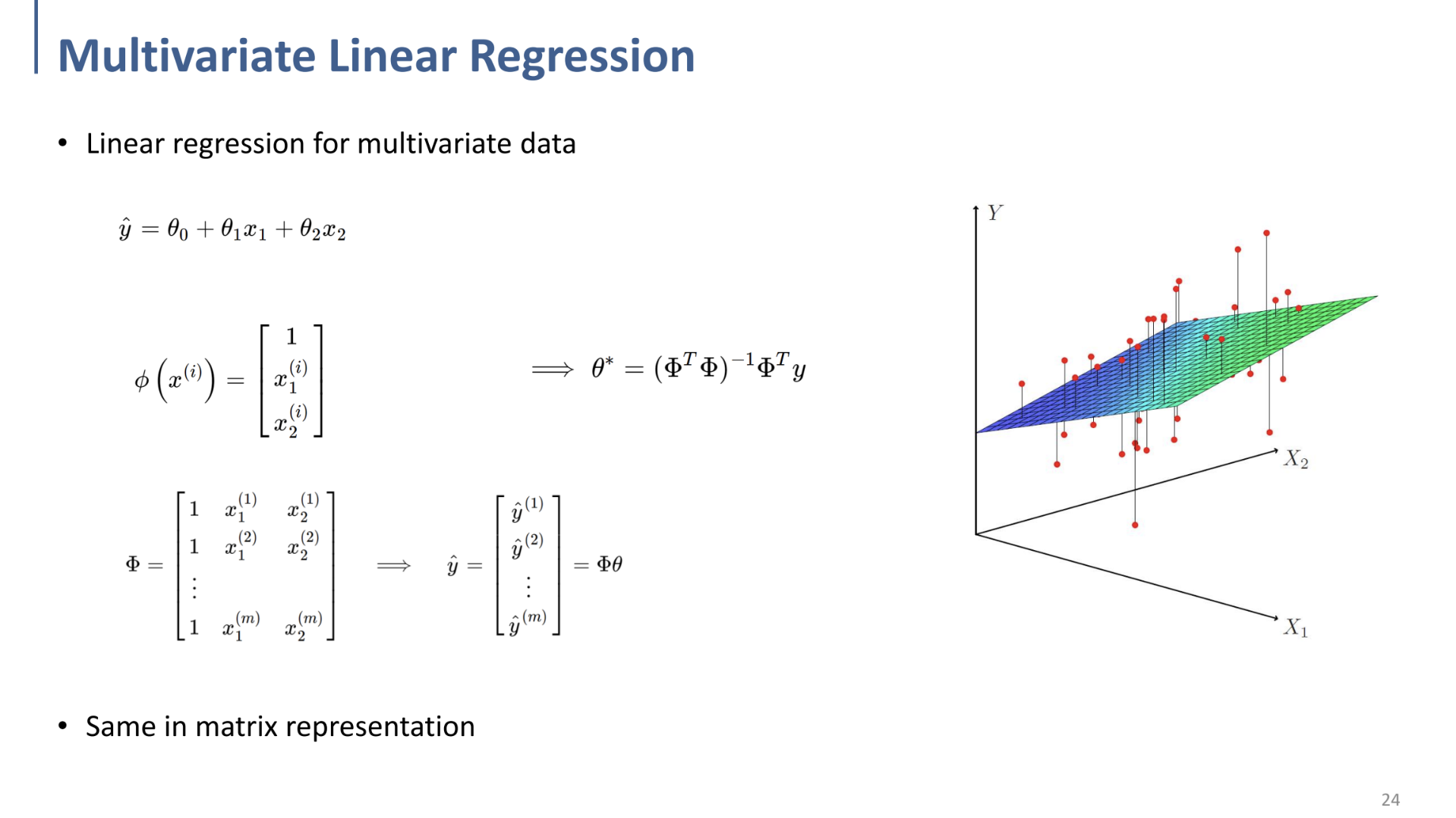

다중 선형 회귀? ⇒ 일반적인 Linear Regression과 동일.

단지 matrix $A$ 에 해당하는 column(feature)의 개수가 더 늘어나는 것 뿐. ($y=Ax$)

Nonlinear Regression.

Linear Regression을 non-linear data에 그대로 적용하는 것.

일반적인 Linear Regression과 동일하나, 단지 data, feature가 non-linear하게 distribute되어 있을 뿐.

⇒ 이 장에서는 Method 1에 대해서만 소개. kernel trick에 대해서는 추후 따로 알아볼 것.

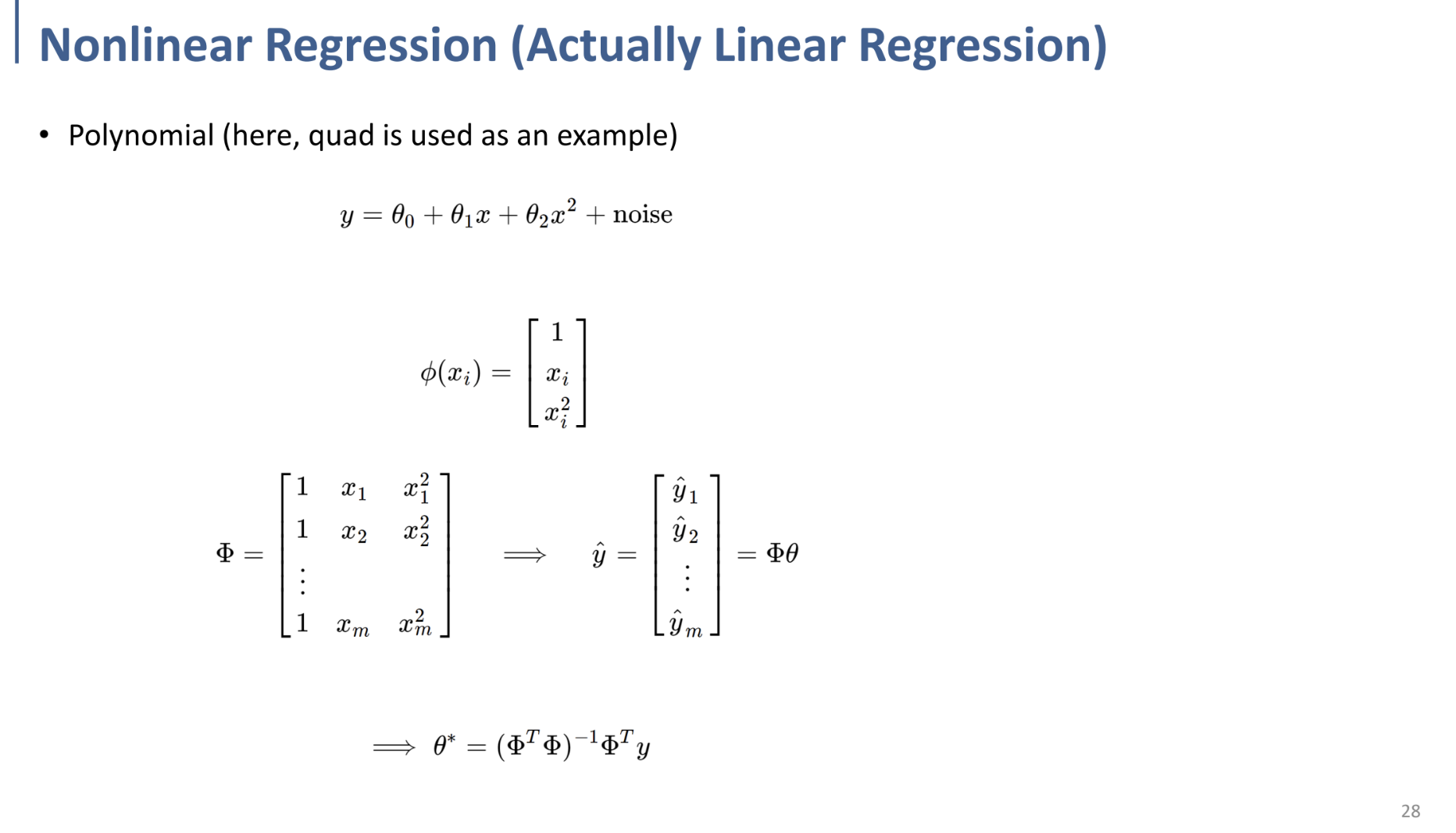

Polynomial Regression ⇒ Multivariate Linear Regression과 거의 동일하다고 생각하면 된다.

$x_2 → x^2$으로 변경되었을 뿐.

여기에서, $x$의 관점에서 보면 비선형적인 것이 맞으나, 결국 $\theta$의 관점(우리가 구하고자 하는 값)에서 보면, Multivariate Linear Regression으로, 선형회귀 문제와 동일하게 볼 수 있는 것이다.

결국 “데이터” 가 선형적인지, 비선형적인지의 차이일 뿐, 선형회귀 문제이다.

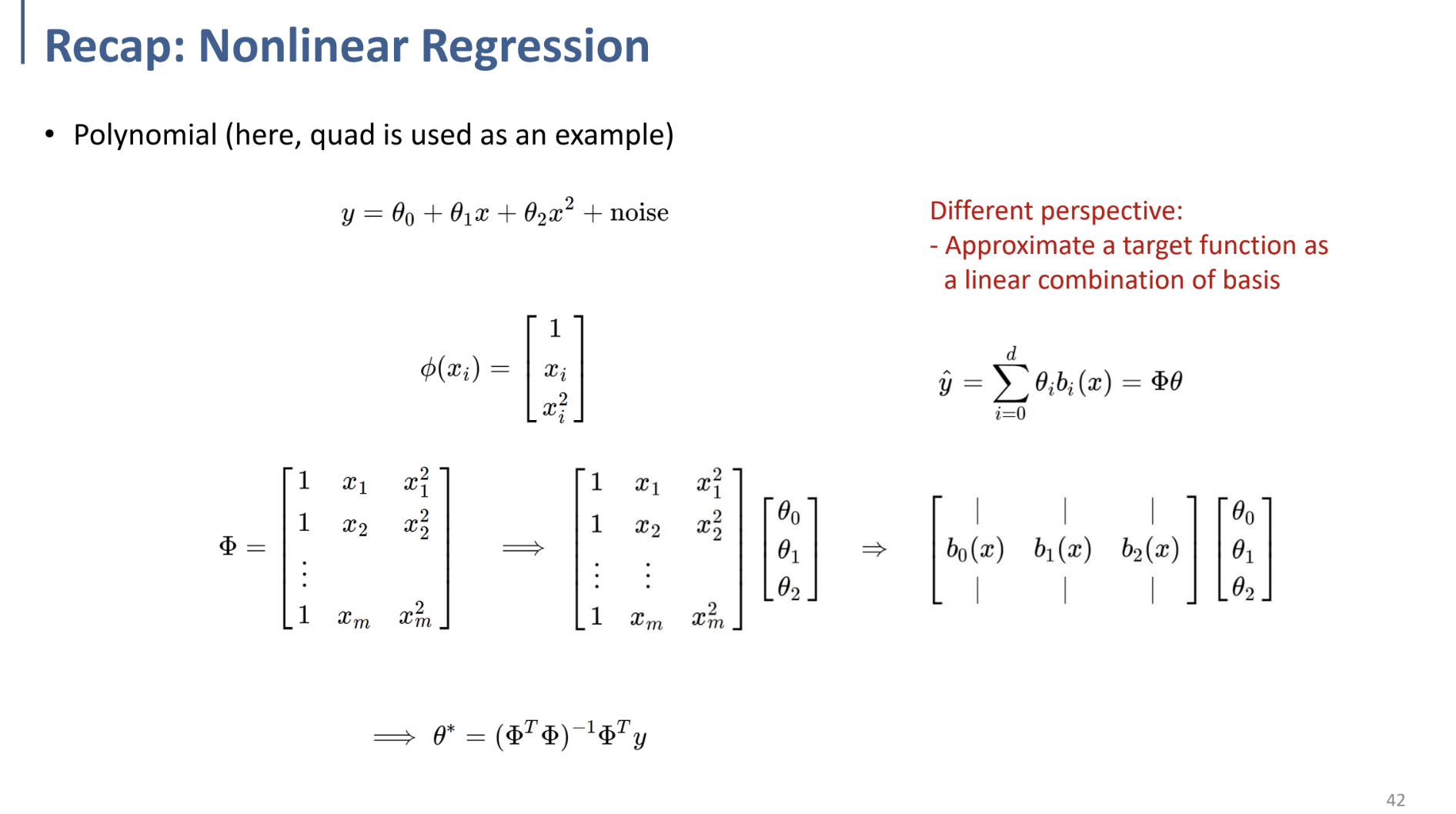

Functional Approximation

Select coefficients among a well-defined function (basis) that closely matches a target function in a task-specific way

→ well-define된 function(basis)에서 target function에 가장 근접하도록 하는 coefficient(계수)를 구하는 것.

** 다른 관점(시각)에서 바라보는 것이다.

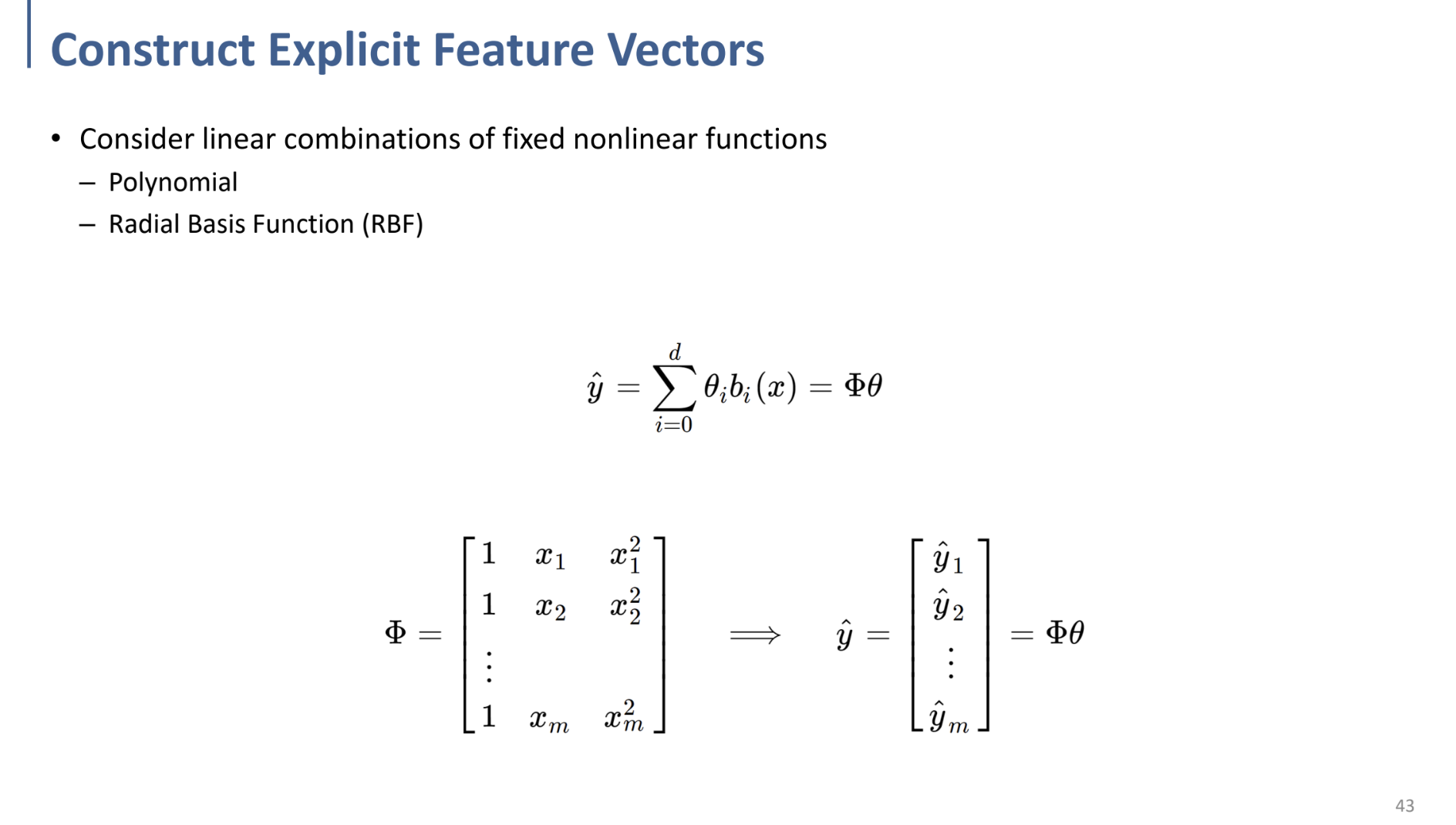

basis의 linear combination ($[b_0(x), b_1(x), b_2(x)]$)을 통해 $\theta$들을 구하는 것.

그러한 basis($b_i(x)$)들은 우리가 정해줘야 하는데, 그 중 유명한 것들이

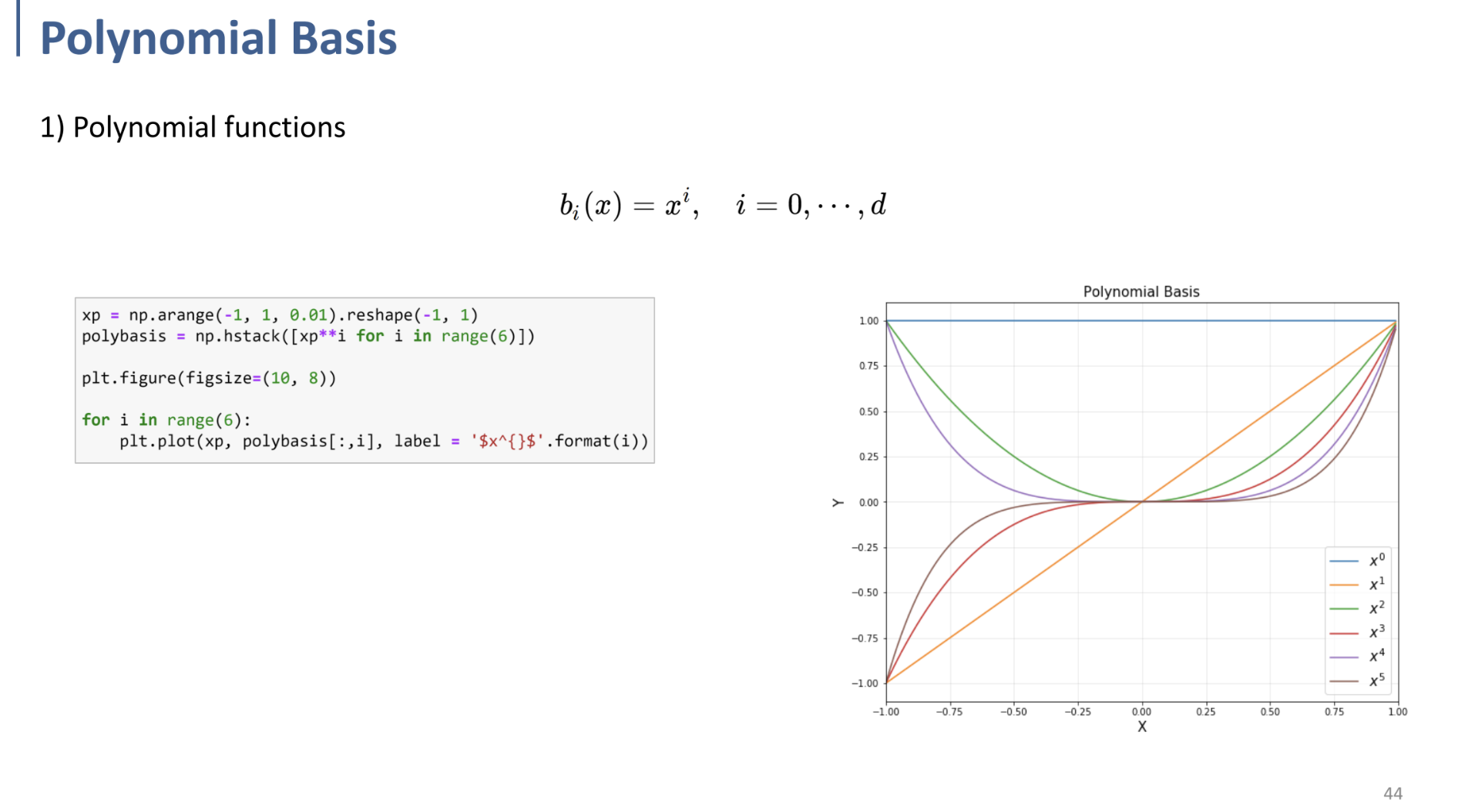

→ Polynomial

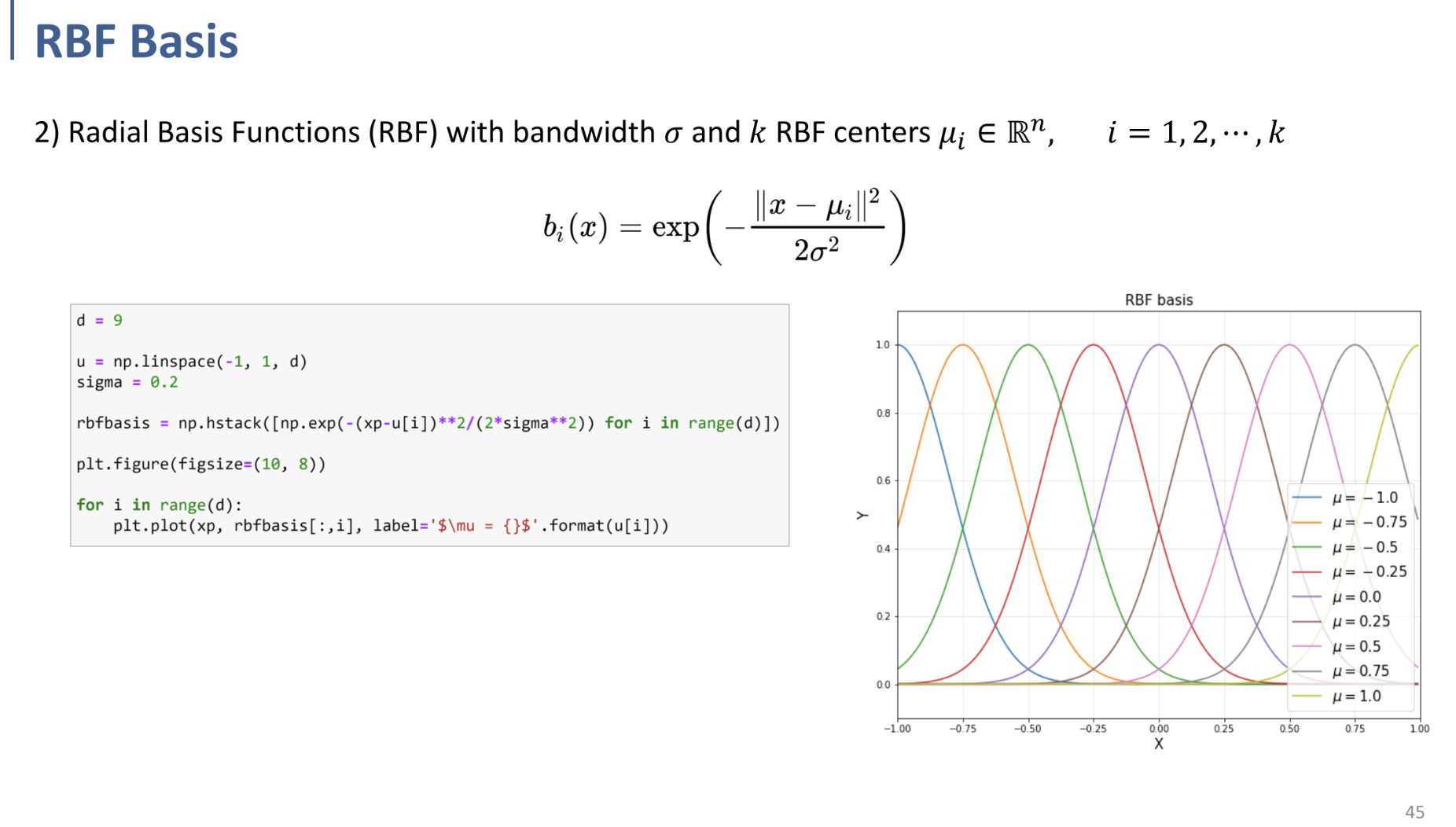

→ RBF (Radial Basis Function)

같은 것들이 있다.

Polynomial 같은 경우는 위의 사진과 같이 basis가 polynomial인 경우를 말하는 것.

위는 Polynomial Basis와 RBF Basis를 시각적으로 보여주는 것.

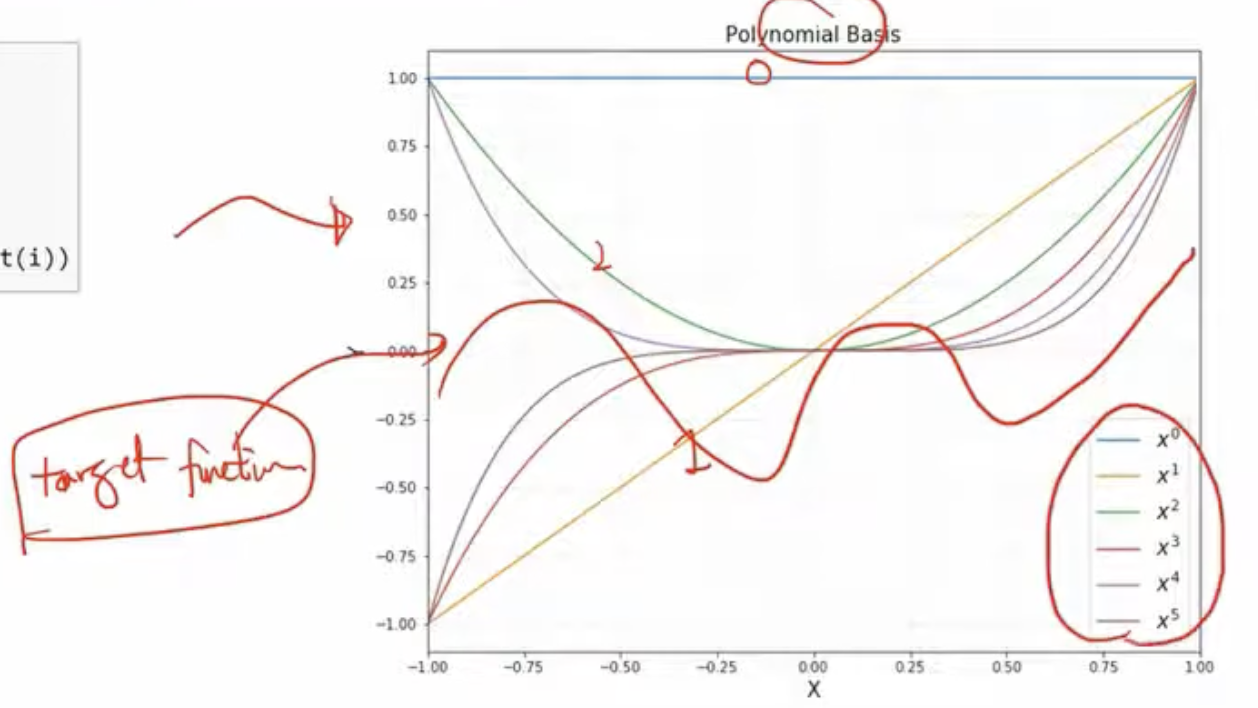

** 위에서 말한 것을 시각적으로 다시 설명하자면,

우측에 빨간 선과 같은 것을 target function이라 하자.

만약 Polynomial basis를 채택하였다면, 저 $x^0, x^1, .., x^6, ..$ 들을 선형 결합하여

target function에 근접하도록(approximate)하겠다는 것이다.

이 설명이 제일 잘 이해될 듯 하다.

마찬가지로, RBF Basis도 위와 같은 식에 의한 선들(basis)들의 선형결합으로 target function을 approximate 하겠다는 것이다.

(참고로, $\mu$는 평균 → 그래프의 중심을 결정하고, $\sigma$는 bandwidth로, 그래프의 상하폭을 결정한다.)